Сохранение сайтов на харде с возможностью их оффлайнового просмотра - тема, по нынешним временам, актуальная. Решается с помощью специализированного софта, выкачивающего структуру сайта и переписывающего внутренние ссылки на локальные, относительно корневого каталога.

Какие имеются нюансы:

1. Большинство сайтов, например наш форум, написаны на PHP и прочем, страницы генерируются по запросу, на основании скриптов и БД (базы данных). Страниц, как таковых, которые показывает браузер, изначально не существует. При скачивании софтина "прозванивает" все возможные ссылки и генерирует структуру из HTML файлов (если упрощённо). То есть, скачав наш форум, можно будет серфить по всем, имевшимся на момент закачки, ссылкам. Но никакого интерактива, типа комментирования, не будет.

2. Часть ценных сайтов уже не существует. До них можно добраться через вебархив, но скачивать такие сайты проблематично.

3. Часть ценных сайтов заблочено на территории скреп, победивших разум. Доступ через VPN или Proxy не представляет проблем, но при скачивании таких сайтов возникают сложности.

Теперь решение:

1) Софт для скачивания сайтов:

1.1) Teleport pro. Есть на трекере, берём ломаную версию "Teleport Pro v 1.70 Final/Portable".

Софтина старая, но годная. Для "простых" сайтов годится. Работает быстро, интерфейс простой, на ангийском. Главное, установить глубину скачивания по ссылкам, иначе получится либо только стартовая страница, либо скачает весь интернет.

Сайт сохраняет в указанной папке, стартовая страница в файле "index.html".

Скачивать с вебархива не умеет.

1.2) HTTrack. Берём безоплано здесь.

Интерфейс странный, но настроек уже побольше и результат получше. Из вебархива качает раз через два. Норовит выкачать всё, до чего можно добраться по ссылкам. Сайты сохраняет в каталоги корневой папки. Доступ к сайтам либо из общего интерфейса веб страницы, либо по файлу "index.html".

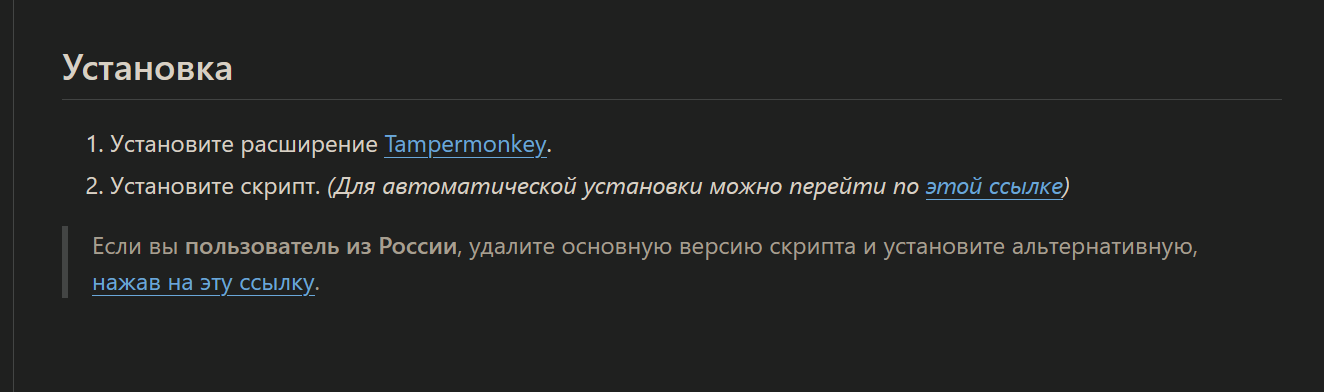

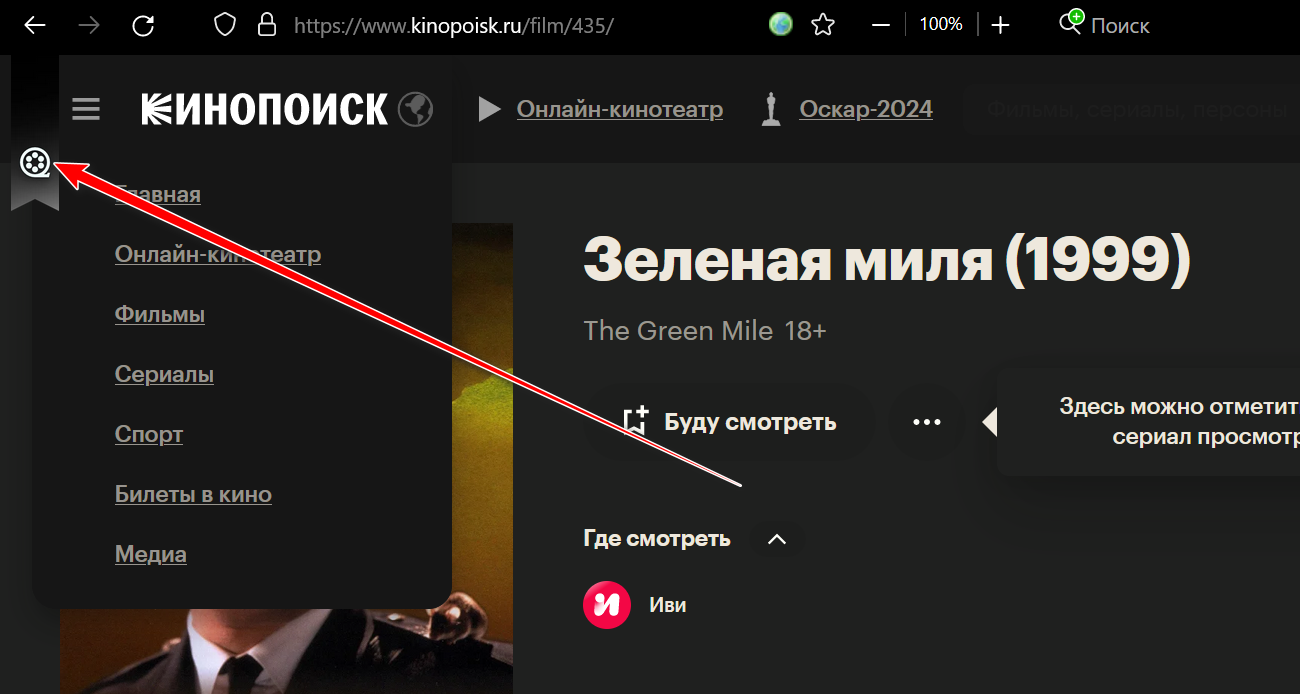

1.3) MetaProducts Offline Explorer Pro. Есть на трекере, ломаная. Последняя версия 8.4, но можно юзать и более раннюю, вплоть до 5.

Самое мощное из имеющегося. Есть мастер, позволяющий сделать настройку закачки. Есть мощная система настроек и современный интерфейс. Умеет качать из вебархива, даже есть соответствующая кнопка в мастере. Сайты сохраняет в своих недрах, откуда их можно экспортировать в выбранное место с формированием стартового файла. Можно сразу указать место сохранения сайта, тогда стартовую страницу придётся поискать в директориях.

Можно (и нужно) выставить ограничение, когда будут выкачивать все файлы по ссылкам, но в пределах либо начального сервера, либо начального домена. Иначе получите несколько гигов мусора.

2. Скачивание из вебархива. Находится тут. Суть в том, что робот сканирует сеть и создаёт копии всех найденных сайтов. На каждый апдейт сайта создаётся новая копия. В строку запроса вставляем адрес нужного сайта и запускаем поиск. По тайм бару смотрим график активности, выбераем год, затем в годовой выборке выбираем день месяца и нужный слепок по времени его создания. Открывается сайт, проверяем - та ли версия. Бывает, домены продаются перед исчезновением и вместо сайта получаем рекламу. Вобщем, ищем нужный слепок, копируем адресную строку браузера.

Например, для сайта zarubezhom.com последний слепок сделан 7 июня 2023 и выглядит так: http://web.archive.org/web/202306071012 … ezhom.com/

Этот адрес используем в программе Offline Explorer, выбрав в мастере пункт закачек из вебархива. Но и тут могут быть проблемы, часто не скачиваются картинки и целые страницы. В самой проге можно запустить просмотр оффлайн сайта и принудительно докачать нужное.

3. Для сайтов, заблоченных в стране вечной радостной охоты, ситуация такая. Можно тупо открыть его через тот же вебархив и скормить Offline Explorer. Встроенного VPN у него нет и напрямую скачать такое он не сможет.

Либо можно включить нечто глобальное, типа ProtonVPN, или прописать в системных настройках работу через прокси сервера.

Через вебархив я скачал, например, сайт arracis.com, вот по этой ссылке

В качестве бонуса: архив с уже упоминавшимся сайтом zarubezhom.com одним файлом на 690 метров.

Карточку незачем светить.

Карточку незачем светить.